Hovedfunn

Medisinske svar fra en kunstig intelligent språkmodell ble oppfattet som mer empatiske, kunnskapsrike og hjelpsomme sammenlignet med svar fra leger.

Flere studier har undersøkt hvordan kunstig intelligens besvarer helserelaterte spørsmål. Generative Pre-training Transformer (GPT) er en kunstig intelligensmodell som kan forstå og generere menneskelig språk. En amerikansk studie publisert i 2023 fant at språkmodellen GPT-3.5 sine svar på engelskspråklige helserelaterte spørsmål ble oppfattet som mer empatiske og kunnskapsrike enn svar fra leger (1). Hvordan svar fra kunstig intelligens oppfattes, kan ha betydelige implikasjoner og stor nytteverdi for helsesektoren.

Siden språk, kultur og medisinske retningslinjer varierer mellom ulike land, ønsket vi å undersøke hvordan personer med helsefaglig bakgrunn i Norge oppfatter svar fra store språkmodeller på helserelaterte spørsmål, sammenlignet med svar fra leger. I tillegg undersøkte vi om svarene ble vurdert ulikt av leger og medisinstudenter med lisens, sammenlignet med personer med annen helsefaglig bakgrunn.

Materiale og metode

192 helserelaterte spørsmål og tilhørende svar fra leger fra nettstedet Studenterspør.no ble inkludert i studien. Studenterspør.no er et nettsted der studenter kan sende inn spørsmål og få svar fra helsepersonell. Svarene publiseres anonymisert. Vi utviklet et script for å samle inn spørsmål og svar fra kategorien «Kropp, sex og identitet» og underkategorien «Sykdom og symptomer». Denne kategorien ble valgt fordi den inneholder varierte helserelaterte spørsmål og har en stor andel spørsmål besvart av lege.

Vi utviklet et sett med instruksjoner for GPT-4 for å sikre at modellens svar hadde ønsket form, lengde, innhold og språk. Vi vektla at svarene fra GPT-4, i likhet med svarene fra Studenterspør.no, ikke skulle oppfattes som helsehjelp, i tråd med helsepersonelloven (2). I stedet skulle de gi helseveiledning og rådgivning, uten å erstatte medisinske råd fra helsepersonell. Instruksjonene ble utviklet iterativt til GPT-4 ga tilfredsstillende svar på et sett testspørsmål. Deretter ble instruksjonssettet låst, og de samme instruksjonene ble brukt på alle spørsmålene i studien. Analyse av resultatene ble utført i Python.

Rekruttering av respondenter skjedde gjennom e-postlister for legevakt, sykehjem og sykehusavdelinger, på stand og postere på Haukeland universitetssjukehus, Facebook-grupper for helsepersonell og direkte kontakt med bekjente innen helsevesenet. Respondentene som oppga å være lege eller medisinstudent med lisens, eller som oppga å jobbe, studere eller ha bakgrunn innen helsevesenet, ble inkludert i studien. Innsamling av data fra de 344 inkluderte respondentene foregikk fra 15. januar til 18. februar 2024.

Spørreundersøkelsen ble distribuert via en egenutviklet webapplikasjon der respondentene kunne lese ett spørsmål med to tilhørende svar om gangen, samt angi sin vurdering for hver av de ulike dimensjonene. I applikasjonen fantes informasjon om personvern og definisjoner av evalueringskriteriene. Deltakerne fikk vite at ett svar var generert av GPT-4, og ett svar var skrevet av lege, men de fikk ikke spesifisert hvilket som var hvilket. Spørsmålene ble tildelt tilfeldig. Respondentene evaluerte dimensjonene empati, kunnskap og hjelpsomhet i svarene ved hjelp av en femdelt Likert-skala. For dimensjonen kunnskap var det i tillegg mulig å svare «vet ikke». Det var mulig å hoppe over spørsmål, og undersøkelsen be avsluttet etter å ha vurdert fem spørsmål, eller tidligere om ønskelig. Det var mulig å gjennomføre undersøkelsen flere ganger.

Utfyllende informasjon om inklusjon av spørsmål, generering av svar, definisjoner av evalueringstermene, analyser og resultater, samt komplette instruksjoner og eksempler på spørsmål og svar, er tilgjengelige her: https://github.com/MMIV-ML/helseveileder.

Resultater

Til sammen 344 inkluderte respondenter vurderte de 192 spørsmålene, og det ble avgitt totalt 1 109 vurderinger av sett med spørsmål og svar. Gjennomsnittlig antall vurderinger per svar var 5,7 (standardavvik 6,7), med medianverdi 5. Nitten respondenter (5,4 %) deltok i studien mer enn én gang. Blant respondentene oppga 44 (12,8 %) å være lege eller medisinstudent med lisens, mens 300 (87,2 %) ikke var lege eller medisinstudent med lisens, men studerte, arbeidet eller hadde bakgrunn innen helsevesenet.

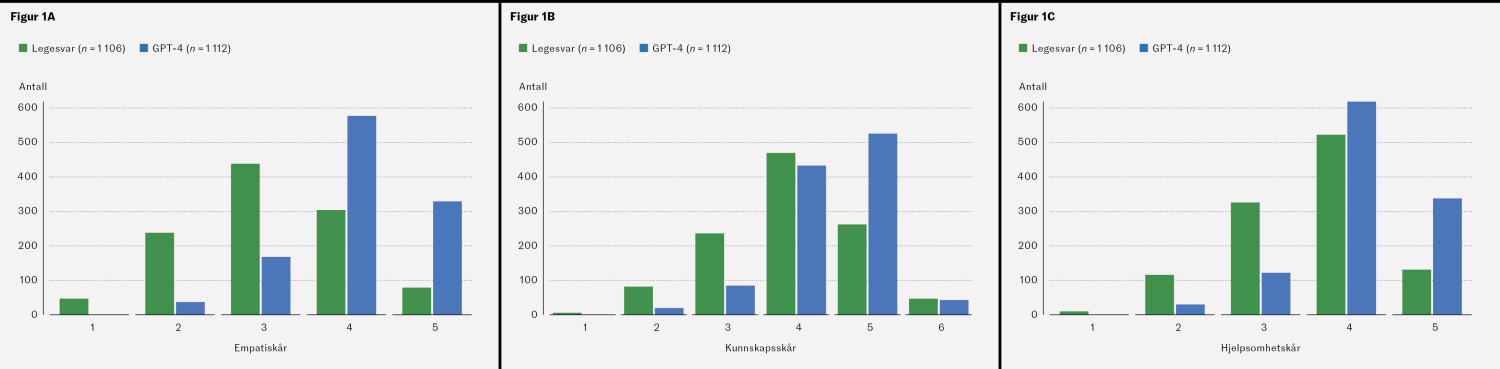

Figur 1 viser respondentenes vurdering av empati, kunnskap og hjelpsomhet. Merk forskyvningen mot høyere skår for GPT-4-svar for alle de tre dimensjonene. Empati: χ2 = 571,26, df =4, p < 0,001, kunnskap: χ2 = 204,24, df =4, p < 0,001 og hjelpsomhet: χ2 = 258,49, df =4, p < 0,001.

Diskusjon

Svar generert av GPT-4 på helserelaterte spørsmål, ble vurdert som mer empatiske, kunnskapsrike og hjelpsomme enn svar fra leger. Våre funn indikerer at respondenter som var leger eller medisinstudenter med lisens, ikke ga en annen vurdering av kunnskap sammenlignet med andre respondenter som jobber, studerer eller har bakgrunn innen helsevesenet.

Funnene i vår studie samsvarer med resultatene fra en tidligere publisert studie (1). Nytteverdien av store språkmodeller er også vist i andre studier. For eksempel viser foreløpige, ikke-fagfellevurderte resultater at svar generert av språkmodeller kan gi høyere diagnostisk nøyaktighet og bedre samtalekvalitet (3), eller at språkmodellers svar på anestesiologiske spørsmål er likeverdige med akademiske ressurser (4). Eksemplene demonstrerer at kunstig intelligens kan gi like gode og noen ganger bedre svar enn leger, og at kunstig intelligens således kan være et nyttig hjelpemiddel.

Imidlertid rapporterer andre studier motstridende funn. En studie viste at leger som besvarte elektroniske pasientspørsmål ved hjelp av svarutkast generert av GPT-4, brukte mer tid på å lese og redigere utkastene, og de sparte ikke tid på å ferdigstille svarene (5). Studien viste også at legenes svar ble lengre. Dette understreker viktigheten av videre utforskning av hvordan integrasjon av denne formen for kunstig intelligens faktisk kan forbedre helsehjelp og avlaste helsepersonell.

I motsetning til studien fra 2023 (1) brukte vi GPT-4 fremfor den eldre GPT-3.5, og vi utviklet spesialtilpassede instruksjoner til modellen. I tillegg til empati og kunnskap undersøkte vi i denne studien også hvor hjelpsomme svarene fra leger og GPT-4 ble oppfattet. Alle respondenter i studien var blindet for om svarene de vurderte var skrevet av leger eller generert av språkmodellen. Våre instruksjoner var tilpasset for å gjøre det vanskelig å identifisere om et svar var generert av kunstig intelligens. I motsetning til tidligere studier var ingen av respondentene i denne studien involvert i utforming eller publikasjon.

En svakhet ved vår studie er muligheten for at svar skrevet av språkmodellen kan gjenkjennes, noe som kan føre til en bekreftelsesbias basert på respondentens holdninger til kunstig intelligens. Vi ba ikke respondentene gjette avsenderen, for å unngå et fokus på dette, men en begrensning er at vi ikke kan vite i hvilken grad de faktisk gjenkjente avsenderen og hvordan dette påvirket resultatene.

Det kan også foreligge en seleksjonsbias dersom de med sterke positive eller negative holdninger er overrepresentert, og de med mer nøytrale holdninger er underrepresentert.

Respondentene oppga selv om de var lege eller medisinstudent med lisens, uten at dette ble kontrollert mot helsepersonellregisteret. Innhenting av flere opplysninger fra respondentene ville gjort det mulig å undersøke betydningen av faktorer som arbeidserfaring og yrke.

Konklusjon

Studien viser at svar på helserelaterte spørsmål generert av språkmodellen GPT-4 ble vurdert som mer empatiske, kunnskapsrike og hjelpsomme enn svar fra leger. Dette indikerer at kunstig intelligens kan avlaste helsepersonell ved å formulere gode svarutkast på helserelaterte spørsmål.

Vi takker Studenterspør.no for samarbeidet og for at vi har fått bruke spørsmål og svar fra deres nettsted.

Artikkelen er fagfellevurdert.

- 1.

Ayers JW, Poliak A, Dredze M et al. Comparing physician and artificial intelligence chatbot responses to patient questions posted to a public social media forum. JAMA Intern Med 2023; 183: 589–96. [PubMed][CrossRef]

- 2.

Helse- og omsorgsdepartementet. LOV-1999-07-02-64. Lov om helsepersonell m.v. (helsepersonelloven). https://lovdata.no/dokument/NL/lov/1999-07-02-64 Lest 10.10.2024.

- 3.

Tu T, Palepu A, Schaekermann M et al. Towards conversational diagnostic AI. arXivorg. Preprint 11.1.2024. https://arxiv.org/abs/2401.05654 Lest 13.10.2024.

- 4.

Segal S, Saha AK, Khanna AK. Appropriateness of answers to common preanesthesia patient questions composed by the large language model GPT-4 compared to human authors. Anesthesiology 2024; 140: 333–5. [PubMed][CrossRef]

- 5.

Tai-Seale M, Baxter SL, Vaida F et al. AI-Generated draft replies integrated into health records and physicians' electronic communication. JAMA Netw Open 2024; 7: e246565. [PubMed][CrossRef]

I en nylig publisert studie i Tidsskrift for Den norske legeforening undersøker medisinstudentene Mork og Mjøs, sammen med sine medforfattere, hvordan kunstig intelligens (KI) svarer på helsespørsmål (1). Studien viser et flott initiativ og en god forståelse for den vitenskapelige metode, særlig ved at de bygger videre på et eksisterende datasett og gjør metodikken sin tilgjengelig via GitHub.

En av de mest interessante aspektene ved studien er tilgangen de har valgt. Ved å bruke et allerede eksisterende datasett, får de mulighet til å analysere store mengder informasjon uten å måtte konstruere et nytt eksperiment fra bunnen av. Dette er en metodisk styrke, men det er også viktig å reflektere over hvem som vurderer svarene KI gir – og hvilken ekspertise disse vurderingene baserer seg på.

Studien baserer seg på vurderinger fra 344 respondenter, men av disse var kun 44 leger eller medisinstudenter. Det innebærer at nesten 90 % av respondentene ikke hadde medisinsk utdanning. Dette reiser et viktig spørsmål: Ville resultatene vært annerledes dersom en større andel av vurderingene kom fra medisinsk kvalifiserte personer?

Leger har en spesialisert kunnskap om diagnostikk, sykdomsforløp og behandlingsalternativer, noe som kan gjøre dem bedre i stand til å vurdere nøyaktigheten og nytteverdien av KI-genererte svar. En interessant oppfølgingsanalyse kunne derfor vært å se på hvordan vurderingene fra leger skiller seg fra de øvrige respondentene. Er det for eksempel slik at leger vurderer KI-svarene som mer eller mindre presise enn lekfolk gjør? Opplever de at KI i større grad gir plausible, men potensielt misvisende svar?

Dersom det viser seg at leger vurderer KI-svarene annerledes enn den generelle befolkningen, kan dette ha flere konsekvenser. Det kan tyde på at ikke-eksperter har en annen oppfatning av hva som utgjør et godt helseråd, noe som kan påvirke hvordan pasienter forholder seg til KI-baserte verktøy. Det kan også indikere at fremtidige evalueringer av slike systemer bør inneholde en tydeligere medisinsk ekspertkomponent for å sikre faglig kvalitet.

Studien av Mork og Mjøs er et viktig bidrag til diskusjonen om KI i helsetjenesten, men den reiser også nye spørsmål som bør utforskes videre. En mer detaljert analyse av vurderingene fra leger kontra ikke-leger kunne vært et naturlig neste steg.

Litteratur

1. Mork TE, Mjøs HG, Nilsen HG et al. Kunstig intelligens og legers svar på helsespørsmål. Tidsskr Nor Legeforen 2025; 145. doi: 10.4045/tidsskr.24.0402

Artikkelen «Kunstig intelligens og legers svar på helsespørsmål» konkluderer (1):

Svarene generert av GPT-4 ble vurdert som mer empatiske, kunnskapsrike og hjelpsomme enn svarene fra leger. Det antyder at kunstig intelligens kan avlaste helsepersonell ved å formulere gode svarutkast på helsespørsmål.

Det er ikke overraskende at kunstig intelligens (KI) kan gi gode svar på gode spørsmål. Resultatene kan imidlertid ikke sees i isolasjon, og gjør det betimelig å minne om risiko ved bruk av ChatGPT eller lignende KI-modeller i klinisk medisinsk praksis.

1. Unøyaktighet og feilinformasjon – KI-modeller kan generere uriktige eller utdaterte medisinske råd, som kan føre til skadelige kliniske beslutninger.

2. Mangel på klinisk skjønn – KI mangler menneskelig intuisjon og profesjonell erfaring, som er avgjørende i komplekse saker som krever nyanserte vurderinger.

3. Skjevhet og etiske bekymringer – KI-modeller trenes på store datasett som kan inneholde skjevheter. Dette kan føre til ulikheter i medisinske anbefalinger, spesielt for underrepresenterte pasientgrupper.

4. Personvern og datasikkerhet – Bruk av KI i pasientinteraksjoner medfører risiko for eksponering av sensitiv helseinformasjon.

5. Juridiske og ansvarsmessige spørsmål – Det er uklart hvem som har ansvaret dersom KI-baserte råd fører til pasientskade – helsepersonell, institusjoner eller KI-utviklere.

6. Overavhengighet av KI – Klinikerne kan bli for avhengige av KI-forslag, noe som kan svekke deres kritiske tenkning og diagnostiske ferdigheter.

7. Mangel på forklarbarhet – KI-modeller fungerer som "svarte bokser". Dette gjør det vanskelig å forstå hvordan de kommer frem til konklusjoner, og skaper utfordringer med åpenhet og tillit.

8. Regulatoriske utfordringer – Nåværende medisinske reguleringer dekker ikke fullt ut KI-integrasjon i klinisk arbeidsflyt.

9. Feilinformasjon til pasienter – Dersom pasienter bruker KI-genererte medisinske råd uten profesjonell oppfølging, kan de feiltolke anbefalingene, utsette nødvendig behandling eller stille feil selvdiagnoser.

Rådet for legeetikk behandlet i 2024 en klage på et legesenters oppfordring til pasienter om bruk av ChatGPT som forberedelse til legetimer. Rådets vurdering var at dette representerte brudd på Etiske regler for leger kapittel I §§ 4 og 9, da ChatGPT ikke er en medisinsk anerkjent metode. Den medisinskfaglige kompetansen ligger hos legen, og kan ikke delegeres til pasientene. Legesenteret har ikke kontroll med kommunikasjonen mellom pasienten og ChatGPT – inkludert viktige aspekter som hvordan OpenAI bruker informasjonen pasienten legger inn, og risikoen for feilinformasjon. Rådet anbefalte innklagede å slutte med å anbefale pasienter å bruke ChatGPT for å forberede seg til legebesøk.

Det nevnes at helsemyndighetene maner til forsiktighet (2).

En opplyst diskusjon om hvordan KI skal brukes på en trygg måte i legenes kliniske virke, og for pasientene, blir avgjørende. Rådet ønsker en debatt om ovennevnte problemstillinger velkommen.

Litteratur:

1. Mork TE, Mjøs HG, Giskegjerde H et al. Kunstig intelligens og legers svar på helsespørsmål. Tidsskr Nor Legeforen 2025; 145. doi: 10.4045/tidsskr.24.0402

2. Dobloug HM. Kunstig intelligens i allmennpraksis: Kjøreregler for trygg og lovlig bruk. Dagens Medisin 6.12.2024. https://www.dagensmedisin.no/digitalisering-fastlegeordningen-fastleger/kunstig-intelligens-i-allmennpraksis-kjoreregler-for-trygg-og-lovlig-bruk/665298 Lest 22.2.2025.

Vi takker Damoun Nassehi for hans kommentar (1) og engasjement i diskusjonen om hvordan kunstig intelligens (KI) svarer på helsespørsmål.

Vi ønsker likevel å presisere en detalj i hans innlegg: Antallet medisinstudenter som vurderte svarene, var høyere enn det han oppgir. Blant respondentene var 44 medisinstudenter med lisens eller leger, men i tillegg deltok en rekke respondenter med annen helsefaglig bakgrunn. En stor andel av disse var medisinstudenter uten lisens, selv om vi ikke har ført detaljert statistikk over deres bakgrunn. Når vi sammenlignet evalueringene fra leger og medisinstudenter med lisens med personer med annen helsefaglig bakgrunn, fant vi imidlertid ingen forskjeller (2).

Studiens resultater må naturligvis tolkes i lys av hvilken medisinsk kompetanse som vurderer KI-genererte svar, og dette er et viktig spørsmål for videre forskning. Oppdager leger nyanser eller svakheter i KI-genererte svar som andre ikke ser? Uansett er det en risiko for at KI-genererte svar sprer feilinformasjon som ved første øyekast kan fremstå troverdig.

Hensikten med vår studie er ikke å anbefale at pasienter bruker KI i stedet for å kontakte lege, eller at helsevesenet skal basere seg på KI-svar som ikke signeres eller kvalitetssikres av lege. Vårt mål er å bidra til et kunnskapsgrunnlag for hvordan KI besvarer medisinske spørsmål fra pasienter, og hvordan KI potensielt kan brukes til å støtte leger i en travel arbeidshverdag — for eksempel ved å utforme svarutkast som kan gi pasientene bedre og mer empatiske tilbakemeldinger.

Litteratur

1. Nassehi D. Hvem bør vurdere kunstig intelligens’ medisinske råd? Tidsskr Nor Legeforen 19.2.2025. https://tidsskriftet.no/2025/02/kommentar/hvem-bor-vurdere-kunstig-intelligens-medisinske-rad#comment-3413 Lest 12.3.2025.

2. Mork TE, Mjøs HE, Nilsen HG et al. Kunstig intelligens og legers svar på helsespørsmål. Tidsskr Nor Legeforen 2025; 145. doi: 10.4045/tidsskr.24.0402